简介

2024年3月15日,苹果公司在一篇名为《MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training》的论文中正式公布自研多模态大模型的研究成果。苹果研究团队在论文中指出,发布MM1模型的主要原因是因为当前大量AI公司在AI模型的学习方法上有着“不透明性”,苹果研究团队认为应该分享建立多模态大型语言模型模型的方法。研究人员在论文中表示,MM1是一个参数多达300亿的多模态模型系列。

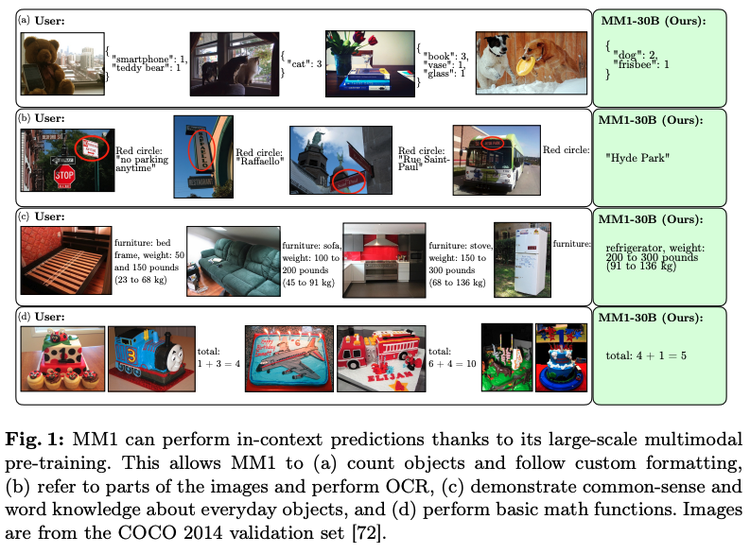

MM1具备不错的图像识别和推理能力,擅长在用户输入的图像和文本中寻找“规则”,此外MM1还具备统计对象并遵循自定义格式,输出文本、参照图像的某些部分并执行 OCR 识别、展示有关日常物品的常识和文字知识、执行基本的数学功能等能力;经过指令调整后,MM1 还具备很强的少量学习能力。

历史沿革

2019年,苹果公司在Giannandre带领下组建了Foundational Models团队来开发大语言模型,苹果大语言模型带头人,参与创造Java的Arthur Van Hoff、苹果大语言模型主推人、苹果公司机器学习和AI战略高级副总裁John Giannandre、苹果最先进大语言模型的训练者、神经网络领域专家Ruoming Pang都对苹果公司的AI大模型发展起了推动作用。2023年9月,The Information曝光苹果公司AI大模型开发团队的核心成员,Arthur Van Hoff、John Giannandre、Ruoming Pang等人均位列其中。根据苹果公司的计划,公司开发AI大模型的预算为每天数百万美元。

2024年3月15日,在一篇由多位作者署名的论文《MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training》中,苹果公司正式公布自研多模态大模型的研究成果,该模型被命名为MM1。

发布原因

苹果研究团队在论文中指出,发布MM1模型的主要原因是因为当前大量AI公司在AI模型的学习方法上有着“不透明性”,行业中现有的MLLM(Multimodal Large Language Model,多模态大型语言模型)主要分为两类:闭源模型和开放模型。闭源模型往往虽然可用,但外界对其数据模型、模型架构和训练细节所知甚少;开放模型,很多公司会将模型参数连同数据模型和训练配置的详细说明一起发布,从而使社区能够在此基础上更进一步微调。在苹果团队看来,无论是开放式的还是封闭式的,大多数的模型对于他们所使用的算法设计选择的过程几乎什么都没有公开,特别是关于多模态预训练,因而为了在该领域进一步研究,苹果研究团队认为,当务之急是分享如何建立这样模型的方法。

技术原理

研究人员在论文中表示,通过在模型架构决策和预训练数据选择上执行小规模消融实验,以及通过对图像编码器、视觉语言连接器和各种预训练数据选择进行细致全面的分析,团队发现了一些关键的设计经验:建模方面,研究人员发现设计的重要性按照图像分辨率、视觉编码器的损耗和容量,以及视觉编码器的预训练数据的顺序依次排列,并使用图像字幕、交错图像文本和纯文本数据三种不同类型的预训练数据。在监督微调(SFT)后,无论是在预训练中使用的评估上,还是在更多基准上,这些趋势都保持不变。最后,通过使用更大的LLM(从 3B、7B 到 30B)以及探索混合专家模型(MoE)(从使用64位专家的3B MoE,到使用32位专家的7B MoE)来扩展苹果的模型,从而建立了MM1,是一个参数多达300亿的多模态模型系列。

功能与应用

由于进行了大规模的多模态预训练,MM1有不错的图像识别和推理能力。更具体地说,Apple MM1 非常擅长在用户输入的图像和文本中寻找“规则”。如下图所示,当用户给出排列的图像,并注明每张上传的图像有关的“对象”和“对象编号”的文本:

除此之外,MM1还具备统计对象并遵循自定义格式,输出文本、参照图像的某些部分并执行 OCR 识别、展示有关日常物品的常识和文字知识、执行基本的数学功能等能力,经过指令调整后,MM1 还具备很强的少量学习能力。

相关评价

值得注意的是,苹果发布的论文中,并没有提及 MM1 是否会发布。MM1 如今只是苹果正式对外的 AI 布局第一步,我们也期待它的进一步。(CSDN 评)